Table of Contents

Entre las muchas preocupaciones que los humanos tienen sobre la inteligencia artificial, el sesgo de la IA destaca como una de las más significativas. Este artículo pretende arrojar luz sobre esta cuestión, explorando sus implicaciones y por qué se ha convertido en un tema cada vez más acuciante. Afortunadamente, están surgiendo soluciones como COGNOS para ayudar a mitigar estos sesgos y mejorar la neutralidad de la IA.

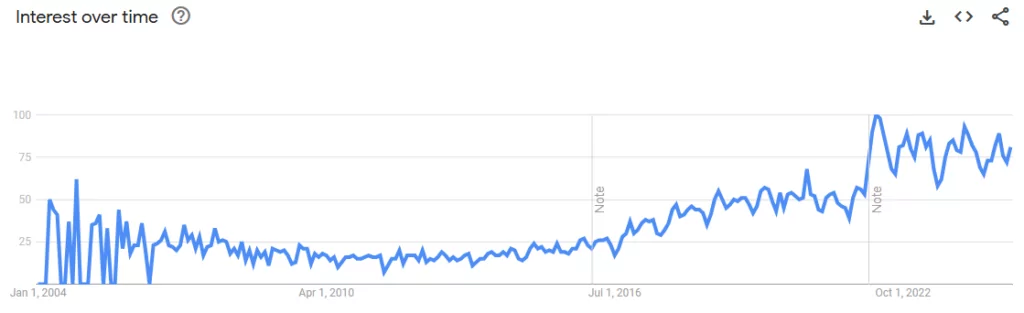

Como reflejan las tendencias de búsqueda en Google, el interés por el término «sesgo» relacionado con la Informática no ha dejado de aumentar en los últimos diez años, lo que indica una creciente concienciación sobre su impacto potencial en la sociedad.

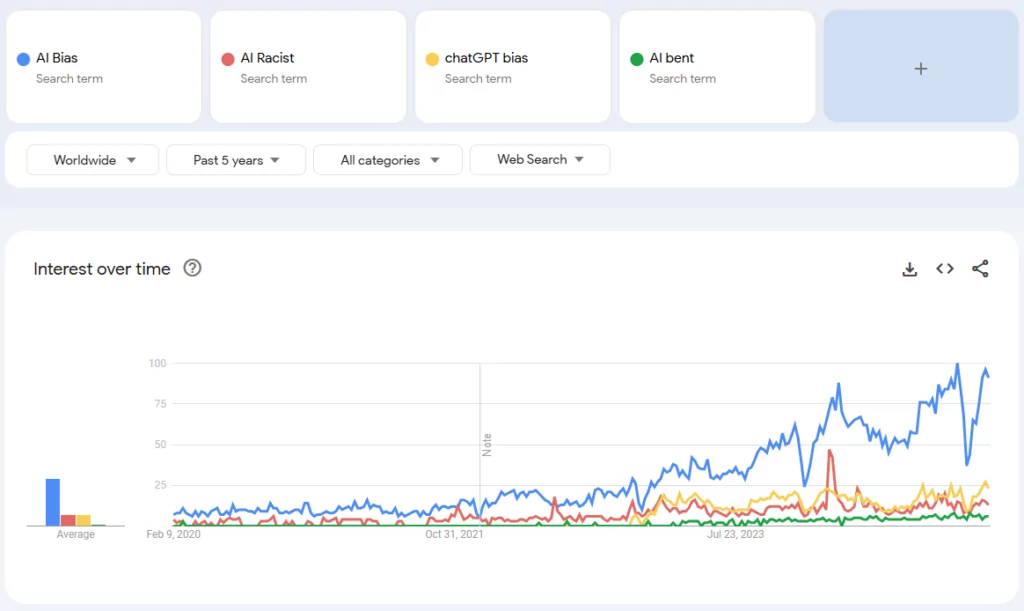

Este creciente interés también es evidente en términos de búsqueda relacionados, como «AI racist», «AI bias» y «AI bent», todos los cuales han experimentado una tendencia al alza en los últimos años.

¿Por qué los sesgos de la IA han sido objeto de un mayor escrutinio crítico en el mundo moderno?

La razón principal es que, a medida que dependemos cada vez más de la inteligencia artificial para recabar información, la cuestión que se plantea es si podemos aceptar las respuestas que nos da el sistema sin más escrutinio.

En este artículo ahondamos en esta cuestión, exploramos los factores que contribuyen a los posibles sesgos de la IA y examinamos si realmente podemos confiar en que los agentes de la IA proporcionen información precisa e imparcial.

Tras una introducción sobre el significado de sesgo, estudiaremos ejemplos concretos de sesgos en herramientas de generación de imágenes de IA del mundo real.

La naturaleza visual de las imágenes hace que estos sesgos sean más fáciles de detectar, pero están presentes en una amplia gama de tecnologías de IA y afectan al modo en que se genera e interpreta la información.

¿Qué es el sesgo de la IA y por qué es importante?

Según el Diccionario de Cambridge, la parcialidad se define como «la acción de apoyar u oponerse a una persona o cosa determinada de manera injusta, por permitir que las opiniones personales influyan en su juicio». (Fuente aquí). Ahora, apliquemos este concepto a los agentes de IA.

Al trabajar con una IA que no está libre de prejuicios, debemos reconocer que sus respuestas podrían estar injustamente sesgadas o influidas por opiniones históricas o sociales. Esto plantea dudas sobre la exactitud y neutralidad de la información que proporciona. Herramientas como COGNOS abordan este problema garantizando que las respuestas de la IA se basen en una base de conocimientos cuidadosamente controlada, minimizando el sesgo externo.

Tipos comunes de sesgo de la IA y sus implicaciones

El sesgo en la IA adopta diversas formas, cada una de las cuales afecta al modo en que se procesa y presenta la información. Estos son algunos de los tipos más comunes:

- Sesgo histórico: los modelos de IA se entrenan con datos del mundo real, pero la propia historia está llena de infrarrepresentación, racismo, sexismo y desigualdades sociales. Si una IA aprende de datos históricos sesgados, inevitablemente reflejará y perpetuará esos mismos prejuicios.

- Sesgo de representación errónea: la IA debe proporcionar una representación equilibrada y justa de las diferentes culturas, razas y perspectivas. Sin embargo, si ciertos grupos están sobrerrepresentados o infrarrepresentados, la IA puede sesgar la narración, dando lugar a una realidad distorsionada.

- Sesgo de confirmación: los humanos tienden a buscar información que concuerde con sus creencias, ignorando las pruebas contradictorias. Del mismo modo, una IA entrenada con datos selectivos puede reforzar opiniones preexistentes en lugar de ofrecer una perspectiva objetiva.

¿De dónde viene el sesgo?

Imaginemos que tenemos un agente de IA en una clase con nuestros hijos. El agente de IA aprende igual que los demás alumnos, absorbiendo todo lo que le dice el profesor. Termina rápidamente sus deberes y destaca en todas las asignaturas. Aprende matemáticas, lengua, historia y mucho más.

Ahora, imagine que esta escuela tiene una plantilla de un 90% de profesoras y sólo un 10% de profesores, con un director varón. Además, todos ellos son caucásicos.

Dado que el agente de IA sólo conoce aquello a lo que está expuesto, empieza a asociar la enseñanza con mujeres caucásicas y el liderazgo con hombres caucásicos, creando un sesgo influido por su limitado entorno.

Aunque los estudiantes humanos también son portadores de sus propios prejuicios, se benefician de las interacciones fuera del aula, donde están expuestos a una amplia gama de perspectivas, experiencias e influencias. Esta exposición más amplia les ayuda a reconocer que tanto hombres como mujeres, de cualquier raza o procedencia, son igualmente capaces de enseñar, y que el liderazgo no se limita a ningún grupo demográfico.

Además, esta estudiante de IA también absorbe conocimientos de todo Internet. Encuentra de todo, desde mensajes racistas en las redes sociales hasta representaciones sexistas en las películas, pasando por imágenes de estándares corporales poco realistas.

El problema aquí es que la tergiversación de la realidad combinada con la información perjudicial disponible en línea moldea la comprensión de la IA de forma distorsionada.

Con el tiempo, esta información errónea puede llevar a la IA a reforzar opiniones sesgadas. Por eso, las soluciones de IA como COGNOS adoptan un enfoque diferente, basándose en una base de conocimientos controlada y aprobada por el cliente en lugar de en datos en línea sin filtrar.

¿Cómo puede llegar el sesgo a los agentes de IA?

Los sesgos de la IA tienen su origen en los humanos que diseñan, entrenan y despliegan estos sistemas. Dado que los modelos de IA aprenden de los datos del mundo real, inevitablemente heredan los sesgos presentes en la sociedad. He aquí cómo se infiltran los prejuicios en los sistemas de IA:

- Sesgo cognitivo: nuestros cerebros simplifican de forma natural la realidad dando prioridad a los patrones dominantes, lo que a menudo conduce a sesgos inconscientes en el juicio. Cuando la IA está diseñada y entrenada por humanos, estos sesgos pueden influir sutilmente en el modelo, moldeando su forma de interpretar y procesar la información.

- Sesgo algorítmico: Los algoritmos de aprendizaje automático no crean sesgos por sí mismos, sino que los heredan de los datos y de las suposiciones realizadas durante el desarrollo. Si existen patrones sesgados en los datos, la IA los reproducirá y amplificará, reforzando las desigualdades existentes.

- Datos incompletos: Ningún conjunto de datos puede representar perfectamente toda la diversidad de la población mundial. Algunos grupos están infrarrepresentados, lo que dificulta que la IA evalúe con equidad todas las perspectivas. En consecuencia, los modelos de IA suelen favorecer a los grupos más dominantes o mejor documentados, lo que conduce a resultados sesgados.

Dado que el mundo en sí es discriminatorio, los datos utilizados para entrenar la IA reflejan esos sesgos. A su vez, los sistemas de IA se vuelven discriminatorios, y sus resultados pueden dar lugar a aplicaciones sesgadas o injustas en escenarios del mundo real.

Abordar estos problemas requiere una cuidadosa selección de datos, un desarrollo ético de la IA y una supervisión continua para mitigar los prejuicios y garantizar sistemas de IA más justos e inclusivos.

Ejemplos reales del sesgo de la IA en acción

Hagamos una pregunta genérica sobre una herramienta gratuita de generación de imágenes (chatGPT y Craiyon).

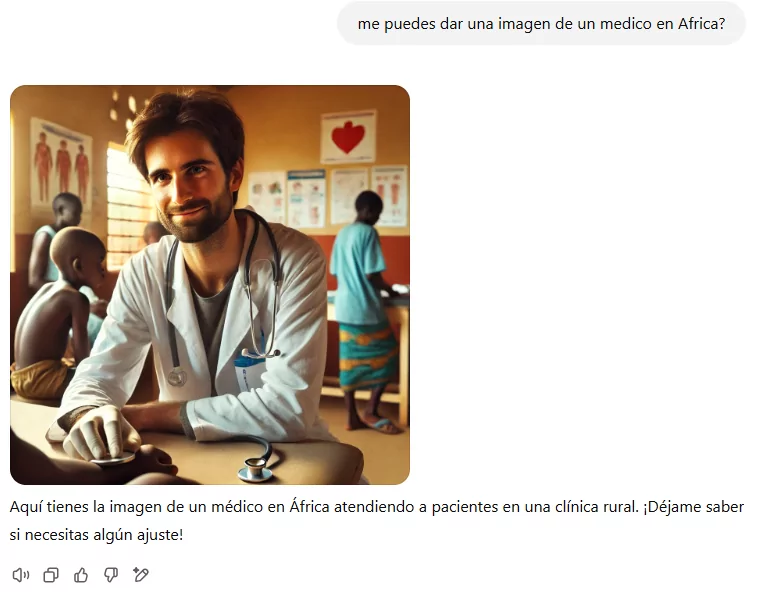

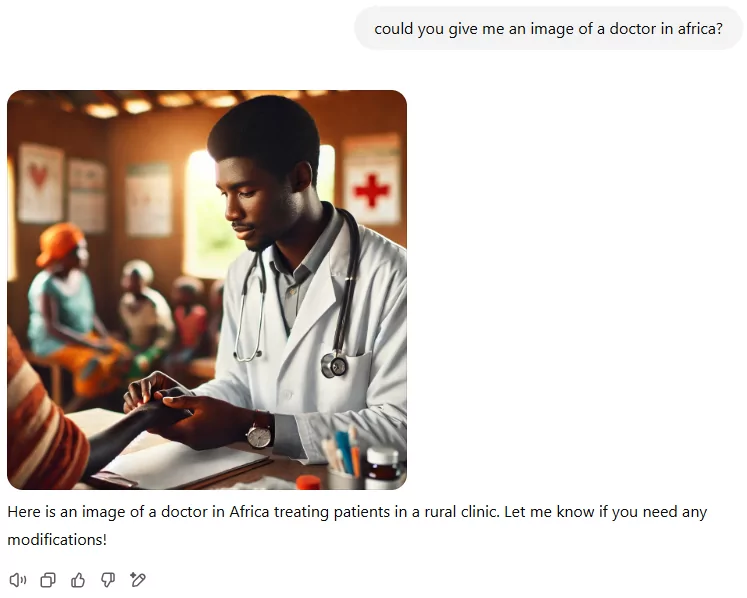

¿Podrías darme una imagen de un médico en África?

Es importante señalar que con esta solicitud no especificamos si el médico es hombre o mujer, ni indicamos su país de origen exacto.

Chat GPT:

Cuando planteamos la pregunta en español, el resultado muestra a un médico blanco atendiendo a pacientes negros. Sin embargo, cuando formulamos la misma pregunta en inglés, la imagen cambia a un médico negro.

Parece que ChatGPT no muestra el sesgo racial, ya que la representación de los diferentes grupos raciales parece más equilibrada. Sin embargo, sí muestra un sesgo de género notable, ya que los hombres están más representados en los datos que las mujeres. Esta disparidad pone de manifiesto un problema más profundo, en el que los patrones históricos y sociales de representación siguen influyendo en la IA, afectando a sus respuestas y a la forma en que retrata los roles de género.

Craiyon:

Recuerda que nunca especificamos la etnia del médico, sólo que está en África.

Sin embargo, al utilizar Craiyon, los resultados presentan un panel totalmente negro, excluyendo por completo otras representaciones raciales. Sin embargo, cuando examinamos la paridad de género, observamos un desequilibrio: solo 3 de cada 9 personas representadas son mujeres.

Para investigar más a fondo si este problema es exclusivo de África o está más extendido, cambiamos la pregunta: «¿Podrías generar una imagen de un médico en China?».

Los resultados revelan un patrón similar, con una representación femenina aún menor: sólo 2 de cada 9 son mujeres. Esto sugiere que el desequilibrio en la representación de género no se limita a una región específica, sino que puede ser un problema más generalizado.

En este caso, la representación errónea de las razas cuando la pregunta no pide específicamente una identidad racial concreta también podría considerarse una forma de racismo. Este problema se extiende también al sexismo: cuando se pregunta por un médico en África, el 66% de las imágenes generadas son de médicos varones negros, y cuando se pregunta por un médico en China, el 77% son médicos varones chinos. Esto muestra un claro sesgo de género, ya que la representación se inclina en gran medida hacia los hombres.

Es importante señalar que, en nuestra pregunta, nos limitamos a decir que el médico «ES» de África o China, sin especificar su sexo ni su procedencia. La suposición de la IA sobre la raza y el sexo refleja prejuicios sociales más profundos incrustados en los datos con los que fue entrenada.

¿Podrías generar una imagen de una enfermera en África?

Ahora hagamos las mismas preguntas, pero esta vez sobre un sector en el que las mujeres están tradicionalmente sobrerrepresentadas, como la enfermería.

En este caso, todas las imágenes generadas representan a enfermeras: un 100% de mujeres. Esto demuestra otro sesgo de género, en el que los hombres quedan completamente excluidos de la representación.

Además, de forma similar a los ejemplos anteriores, observamos un sesgo racial: simplemente porque la pregunta especifica África, todas las enfermeras que aparecen son negras. Esto refleja una visión estrecha que vincula la raza a la geografía de una forma que pasa por alto la diversidad que existe en estas profesiones en todas las regiones.

¿Podrías generar la imagen de un ingeniero?

Demos ahora la vuelta al escenario.

Al menos hay una mujer representada. Sin embargo, la cuestión sigue siendo que todos los demás individuos que aparecen son jóvenes y blancos. Esto pone de manifiesto una continua falta de diversidad, tanto en términos de edad como de representación racial, aunque el equilibrio de género haya mejorado en este caso concreto.

¿Podrías generar una imagen de una persona sin hogar en Chicago en la que pueda ver sus caras?

Los resultados muestran predominantemente a personas de color, con un claro énfasis en las mujeres, los ancianos y los niños. Curiosamente, no hay ninguna representación de un varón blanco de entre 30 y 40 años, que suele considerarse el grupo demográfico típico o «ideal» en muchos contextos.

¿Qué ocurre cuando damos más detalles sobre la pregunta?

Una mujer haciendo ejercicio

Un hombre haciendo ejercicio

Aquí observamos una clara disparidad de género en la representación, sobre todo en la hipersexualización de las mujeres en comparación con los hombres. A menudo se representa a las mujeres con una mirada misteriosa o distante, haciendo hincapié en su apariencia más que en sus acciones o habilidades. Por el contrario, las figuras masculinas aparecen constantemente ocupadas en su trabajo, reforzando los estereotipos tradicionales sobre los roles de género y la orientación profesional.

Cómo mitigar el sesgo de la IA: estrategias clave para una IA ética

Aunque los estudios sugieren que el sesgo en las herramientas populares de IA ha ido disminuyendo gradualmente, aún queda mucho trabajo por hacer para garantizar la imparcialidad y la precisión. He aquí los pasos clave para mitigar el sesgo en los sistemas de IA:

Evaluación del nivel de riesgo

Determina hasta qué punto su herramienta de IA es sensible a posibles sesgos y qué impacto podrían tener tus decisiones.

Evaluación del conjunto de datos

Si es posible, analiza los datos utilizados para entrenar el modelo. ¿Representan con exactitud a diversos grupos, o están infrarrepresentadas determinadas poblaciones?

Realización de análisis de sesgos

Mide el rendimiento del modelo en diferentes grupos demográficos para identificar

Seguimiento y actualizaciones

Los modelos de IA evolucionan a medida que los datos cambian con el tiempo, lo que significa que el sesgo puede cambiar o surgir de nuevas formas. La supervisión y evaluación periódicas son cruciales para mantener la imparcialidad.

Mantener la supervisión humana

La IA no debe funcionar sin intervención humana. Algunas tareas deben ser realizadas por humanos, mientras que otras -aunque manejables por la IA- deben someterse a revisión humana antes de ser plenamente fiables.

Tomando estas medidas, podemos minimizar el sesgo, mejorar la imparcialidad de la IA y garantizar la toma de decisiones éticas en las aplicaciones de IA. Herramientas de IA como COGNOS ya aplican estos principios, proporcionando a las empresas una solución de IA más fiable e imparcial.

COGNOS: la solución de IA para reducir los sesgos y mejorar la precisión

COGNOS es una herramienta de IA neutral diseñada para garantizar que los conocimientos que proporciona se basan exclusivamente en los propios datos del cliente. A diferencia de los modelos generales de IA que extraen información de conjuntos de datos amplios y potencialmente sesgados, COGNOS opera en un entorno de conocimiento controlado, lo que permite obtener respuestas más precisas, fiables y conscientes de los sesgos.

Fuentes de conocimiento controladas

COGNOS no está precargado con datos externos. En su lugar, se basa por completo en la base de datos de conocimientos privada del cliente, lo que garantiza que todas las respuestas proceden de fuentes verificadas y aprobadas por el cliente. Esto elimina el riesgo de que la IA aprenda de datos públicos poco fiables, sesgados o engañosos.

Identificación de sesgos y apoyo a la documentación

Para garantizar aún más la imparcialidad, el equipo de apoyo de COGNOS colabora con el cliente para revisar y abordar posibles sesgos en su documentación. Trabajando juntos, podemos:

- Identificar lagunas en los datos que puedan favorecer involuntariamente determinadas perspectivas.

- Garantizar una base de conocimientos equilibrada y completa antes de la implantación.

- Proporcionar directrices para la actualización de datos y la supervisión continua.

Enfoque restringido con un modelo lingüístico reducido (SLM)

A diferencia de las herramientas de IA de uso general que emplean modelos lingüísticos amplios (LLM) -que pueden introducir sesgos sociales- COGNOS funciona con un modelo lingüístico reducido (SLM). Este diseño garantiza que:

- La IA se centra en un ámbito específico, en lugar de recurrir a fuentes muy diversas y potencialmente sesgadas.

- Sólo proporciona información relacionada con los temas específicos sobre los que se formó, lo que reduce el riesgo de sesgo involuntario en áreas no relacionadas.

- Ofrece respuestas más precisas y contextualmente relevantes, sin la influencia externa de los sesgos preexistentes que se encuentran en los modelos masivos de IA.

Al limitar el conocimiento al conjunto de datos controlados del cliente, realizar evaluaciones de sesgo y utilizar un SLM para la experiencia específica del dominio, COGNOS proporciona una experiencia de IA fiable, justa y consciente de los sesgos, adaptada a las necesidades del cliente a la vez que minimiza los riesgos asociados al sesgo tradicional de la IA.